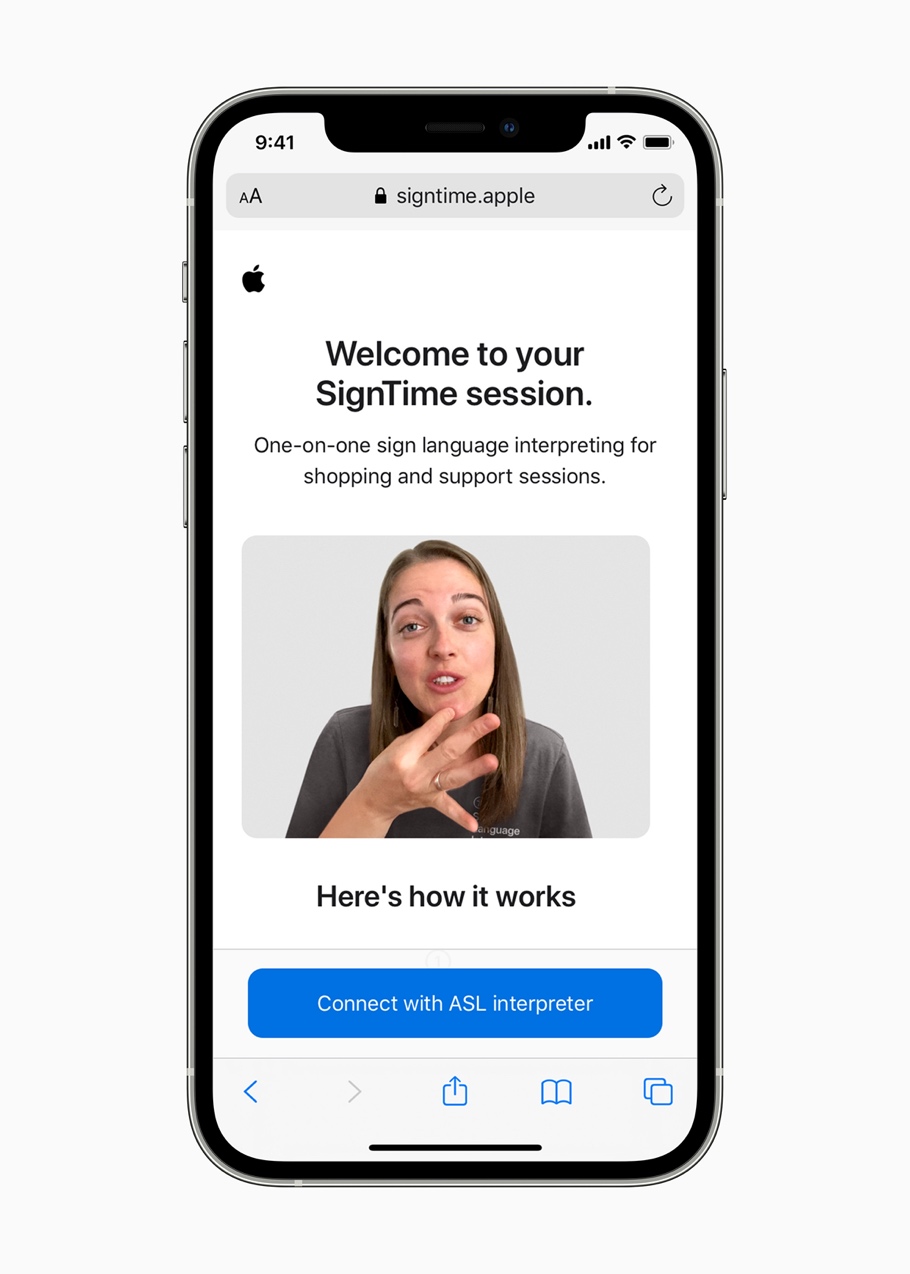

Entre ellas se destaca SignTime, que permite comunicarse mediante lenguaje de señas en las videollamadas

Apple anunció una variedad de funciones nuevas y actualizadas para personas con discapacidades cognitivas, auditivas, visuales y de movilidad.

A partir de hoy, 20 de mayo, los usuarios pueden utilizar el nuevo servicio de interpretación de lenguaje de señas llamado SignTime para ponerse en contacto con Apple Care y el servicio de atención al cliente a través de sus navegadores web.

Por lo pronto esta opción estará disponible en Estados Unidos, Reino Unido y Francia para eventualmente desembarcar en otros países y regiones.

A su vez, actualizaciones de software a finales de este año para iOS, watchOS y iPadOS traerán opciones mejoradas para Assistive Touch, VoiceOver (el reconocido lector de pantalla de la compañía que lee lo que se ve en el display), compatibilidad con auriculares y sonidos de fondo.

Para ayudar a los usuarios con movilidad limitada, la compañía sumó una nueva función de accesibilidad para Apple Watch. Se trata de AssistiveTouch para watchOS, que permite a los usuarios con diferencias en las extremidades superiores del cuerpo disfrutar de los beneficios del Apple Watch sin tener que tocar la pantalla o los controles.

Emplea sensores de movimiento integrados como el giroscopio y el acelerómetro, junto con el sensor óptico de frecuencia cardíaca y el aprendizaje automático en el dispositivo. De este modo Apple Watch puede detectar diferencias sutiles en el movimiento de los músculos y la actividad de los tendones, lo cual les permite a los usuarios navegar por un cursor en la pantalla a través de una serie de gestos, como pellizcar con los dedos o cerrar el puño de la mano.

Esta herramienta les permite a los usuarios que tienen diferencias en las extremidades responder más fácilmente las llamadas entrantes, controlar un puntero de movimiento en pantalla y acceder al centro de notificaciones y de control, entre otras opciones.

Otra de las novedades es que iPadOS admitirá dispositivos de seguimiento ocular de terceros, lo cual permitirá que las personas controlen el iPad con solo sus ojos. A fin de año, los dispositivos MFi compatibles rastrearán dónde está mirando una persona en la pantalla y el puntero se moverá para seguir la mirada de la persona.

Apple también sumó nuevas funciones para su lector de pantalla VoiceOver, para personas con baja visión o ceguera. Sobre la base de las actualizaciones recientes que llevaron las descripciones de imágenes a VoiceOver, los usuarios ahora pueden explorar aún más detalles sobre las personas, el texto, los datos de las tablas y otros objetos dentro de las imágenes.

El sistema también puede describir la posición de una persona junto con otros objetos dentro de las imágenes, para que los usuarios puedan revivir recuerdos en detalle, y con Markup, los usuarios pueden agregar sus propias descripciones de imágenes para personalizar las fotos familiares.

En el marco de una actualización del programa de dispositivos auditivos MFi, la empresa está agregando soporte para nuevos audífonos bidireccionales. Los micrófonos de estos nuevos audífonos permiten a las personas sordas o con problemas de audición tener conversaciones telefónicas con manos libres y FaceTime. Los modelos de próxima generación de los usuarios de MFi estarán disponibles a finales de este año.

La compañía también está brindando soporte para reconocer audiogramas (gráficos que muestran los resultados de una prueba de audición) en las adaptaciones de auriculares. Los usuarios pueden personalizar su audio con los últimos resultados de las pruebas de audición importados de un audiograma en papel o PDF. Las adaptaciones para auriculares amplifican los sonidos suaves y ajustan ciertas frecuencias para adaptarse a la audición del usuario.

A su vez, se sumarán nuevos sonidos de fondo para ayudar a minimizar las distracciones y contribuir a que los usuarios puedan concentrarse, mantener la calma o descansar.

Entre las novedades que llegarán a fin de año se incluyen las acciones de sonido para el control de interruptores que reemplazan los botones físicos y los interruptores con sonidos de la boca, como un clic, un pop o un sonido de “ee”, para usuarios que no hablan y tienen movilidad limitada.

Los ajustes de tamaño de pantalla y texto se podrán personalizar en cada aplicación para usuarios con daltonismo u otros problemas de visión de modo tal que el display sea más fácil de ver.

Por último nuevas personalizaciones de Memoji representarán mejor a los usuarios con tubos de oxígeno e implantes cocleares.

Fuente: Infobae